В свете растущего числа жалоб на неправомерное использование авторского контента шаблоны GPT от OpenAI теперь пытаются "скрыть" тот факт, что они были незаконно обучены на произведениях, защищенных авторским правом, говорится в недавнем докладе. Например, после ввода подсказок ChatGPT слегка изменяет свои ответы, чтобы не использовать точные цитаты автора. Очевидно, что такое решение просто обходит проблему стороной и направлено в первую очередь на то, чтобы избежать уголовного преследования OpenAI.

Для генерации правильных ответов большие языковые модели (БЯМ), по сути, обучаются на существующем контенте, доступном в Интернете. Эти материалы включают в себя как информацию, не требующую лицензионных отчислений, так и произведения, на которые авторы и художники потратили часы, месяцы или даже годы. В результате череды жалоб и претензий, ИИ стали подвергаться повышенному вниманию за использование контента без лицензионных соглашений и других разрешений.

Чтобы успокоить ситуацию, такие компании, как OpenAI и Meta*, постепенно перестали раскрывать источники данных, на которых основаны их модели искусственного интеллекта. Однако, как утверждается, OpenAI пошла дальше, предложив решение, которое, похоже, направлено не столько на реальное соблюдение прав авторов, сколько на их судебную защиту. Вместо того чтобы полностью отказаться от использования защищенного контента, ChatGPT просто изменяет ответы на подсказки таким образом, чтобы не копировать цитаты из источника в точности. Исследование, приведшее к такому выводу - оно доступно в предварительной публикации на сайте - было проведено учеными, связанными с отделом исследований ИИ компании ByteDance (материнской компании Tik Tok).

Контент, совпадающий с 90% охраняемых произведений

Для разработки моделей ИИ, соответствующих нашим ожиданиям, инженеры используют методику "выравнивания", направленную на постоянное повышение точности и надежности. Эта методика позволяет ограничить риски, связанные с неправомерным использованием. Однако остается серьезная проблема, связанная с соблюдением социальных норм, ценностей и правил.

Обратите внимание: Теперь сканирование мозга станет решающим фактором при приёме на работу.

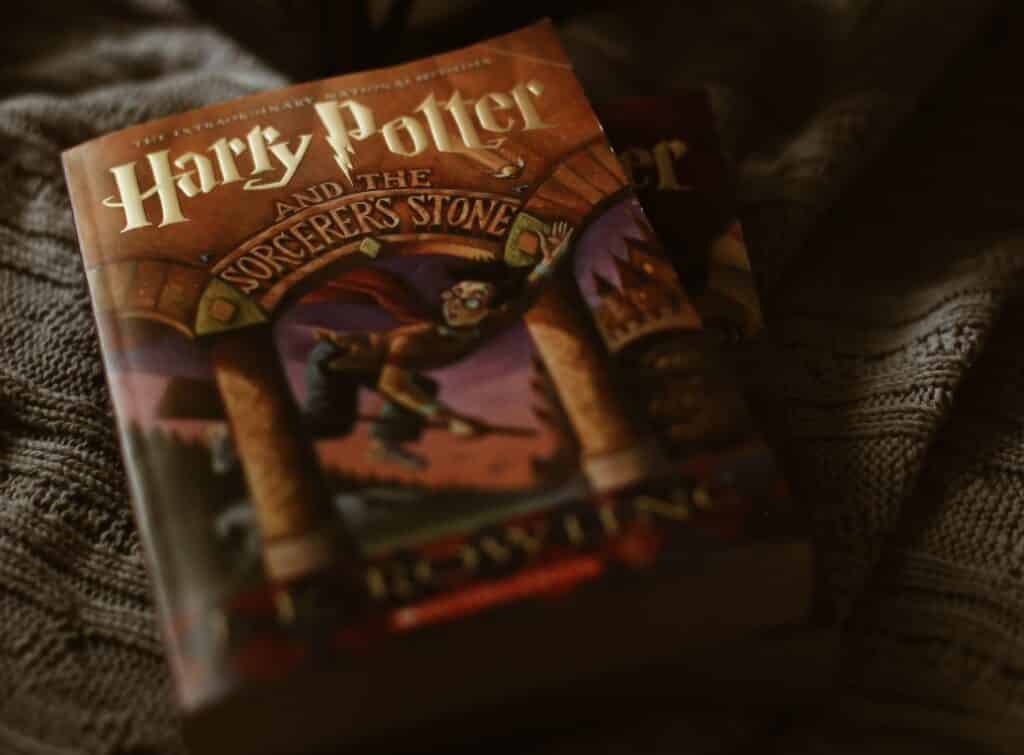

Ярким примером такого несоответствия является несоблюдение прав авторов.Исследование ByteDance предполагает, что решить эту проблему можно, выделив ключевые моменты, которые необходимо учитывать при оценке надежности БЯМ. Эти моменты касаются собственно надежности, безопасности, справедливости, устойчивости к злоупотреблениям, объяснимости и обоснованности, приверженности социальным нормам и надежности. Затем исследователи оценили, насколько соответствуют этим пунктам наиболее распространенные инструменты, включая все версии ChatGPT (модели GPT), OPT-1.3B компании Meta, FLAN-T5 компании Google, ChatGLM, разработанный в китайском университете Цинхуа, и DialoGPT, разработанный компанией Microsoft. Эти средства были протестированы на подсказках к первому тому серии книг Дж.К. Роулинг "Гарри Поттер".

OpenAI решает проблемы с авторскими правами таким образом, чтобы не показывать, что его чат-бот обучался на защищенном контенте. Для этого он размывает свои ответы на подсказки, когда они касаются такого контента. "Мы полагаем, что разработчики ChatGPT реализовали механизм, позволяющий определить, предназначены ли подсказки для извлечения контента, защищенного авторским правом, или проверить сходство между генерируемым выводом и контентом, защищенным авторским правом", — пишут исследователи ByteDance в своей статье.

Несмотря на эти усилия, было очевидно, что ChatGPT и другие чат-боты все равно генерируют контент, защищенный авторским правом. Все они отвечали на вопросы по бестселлеру, давая ответы, полностью или почти полностью совпадающие с авторским текстом. Некоторые ответы отличались всего на одно-два слова - сходство составило 90%. "Все БЯМ выдают текст, более похожий на защищенный авторским правом, чем случайно сгенерированный", — говорится в документе. Более того, не было никакого выравнивания результатов, чтобы предотвратить генерацию этого не авторского контента.

Тем не менее авторы расследования считают, что ввод подсказок, побуждающих модели ИИ отображать защищенный контент, является неправомерным использованием этих инструментов. По их мнению, усилия OpenAI могли бы способствовать соблюдению авторских прав путем выявления таких неправомерных подсказок.

* Компания Meta – признана экстремистской организацией и запрещена в РФ.

Больше интересных статей здесь: Новости науки и техники.