Смотреть видео без замедлений и VPN

Недавний релиз ChatGPT 5 от OpenAI вновь подогрел дискуссии о возможностях искусственного интеллекта. Спектр мнений широк: одни уверены, что нейросети уже обладают зачатками мышления и сознания, другие категорически отрицают такую возможность, считая её принципиально недостижимой. Например, профессор Сергей Савельев называет ИИ «разводом на деньги» и утверждает, что для создания динамически обучающейся нейросети потребуется постоянно перепаивать процессор, а современные системы слишком примитивны, поскольку не могут перебрать все комбинации слов. Между этими крайностями есть и промежуточная позиция: возможно, сознание у машин появится в будущем. В этой статье мы разберем ключевые аргументы в этом споре, а чтобы взгляд был сбалансированным, к обсуждению привлечен эксперт по ИИ, автор книги «Охота на электроовец» Сергей Марков.

Книгу, кстати, рекомендую.

Осознанное мышление: имитация или реальность?

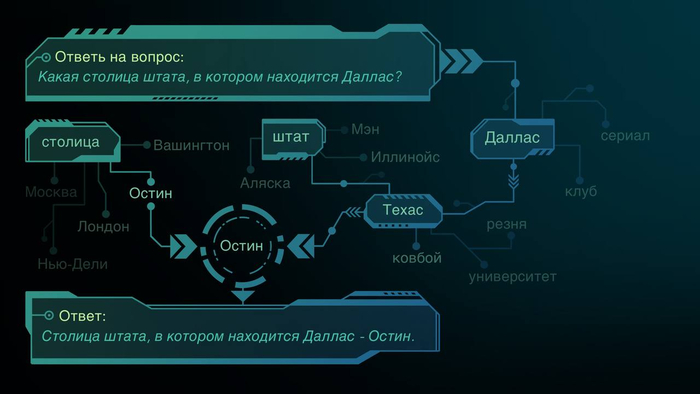

Многие исследователи скептически оценивают потенциал современных нейросетей. Физик Сабина Хоссенфельдер в своем видео разбирает исследование, где с помощью «графов атрибуции» изучалась работа модели Claude 3.5 Haiku. Этот метод позволяет визуализировать цепочку рассуждений модели от запроса к ответу. Например, на вопрос о столице штата, где находится Даллас, модель активирует внутренние представления (фичи): «Даллас» → «Техас» → «Остин». Это выглядит как многоуровневое рассуждение, схожее с человеческим. Модель даже демонстрирует элементы планирования, сочиняя стихи: сначала выбирает рифмующиеся слова, а затем строит строку.

Однако возникает нюанс. Когда та же модель выполняет арифметическое действие (например, 36+59=95) и затем описывает его как человек («6+9=15, пять пишем, один в уме»), анализ её внутренней работы показывает, что реальный вычислительный процесс был иным. Модель, по сути, генерирует правдоподобное, но не соответствующее действительности объяснение. Хоссенфельдер делает вывод: разумное существо должно понимать и верно описывать свои мыслительные процессы, а пока что мы видим лишь имитацию.

Но справедливо ли требовать от ИИ того, чего не можем мы сами? Мы не осознаем, как именно в нашей голове возникает образ или воспоминание. Нейробиологические эксперименты (например, Питера Джохансона с подменой фотографий) показывают, что мозг часто постфактум придумывает логичные, но ложные объяснения нашим решениям, истинные причины которых могут быть связаны с биохимией (тем же куриным супом). Мы не отслеживаем все факторы, влияющие на наш выбор. Поэтому требовать от нейросети полной прозрачности и осознанности каждого шага — это двойной стандарт.

Простое предугадывание или сложный процесс?

Распространенный аргумент: языковые модели не мыслят, а лишь предсказывают следующее слово в последовательности. Но почему тогда эта «простая» предсказательная способность порой приводит к результатам, превосходящим человеческие? Наш собственный мозг во многом работает по схожему принципу: строя фразу, мы тоже не знаем её точного окончания и подбираем слова на основе прошлого опыта (нашей «обучающей выборки»). Нейроны в мозге связаны ассоциативно: мысль о «Ведьмаке» слегка активирует мысли о связанных с ним персонажах. Таким образом, принципиальное отличие между биологическим и искусственным «предсказанием» еще нужно доказать.

Мозг как нейросеть: преодолим ли барьер субстрата?

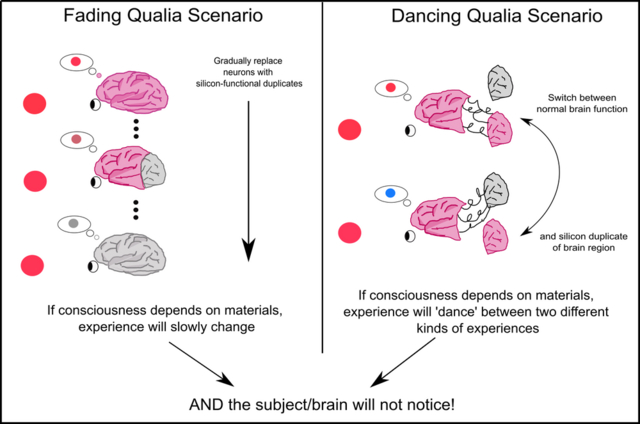

Третий аргумент скептиков: сознание возможно только в особом биологическом субстрате. Однако мозг — это тоже нейросеть, чья работа определяется нейронами и связями. Теорема Тьюринга об универсальной машине утверждает, что любой вычислительный процесс (а работа мозга, вероятно, может быть описана как очень сложный алгоритм) можно имитировать на компьютере. Мысленный эксперимент Дэвида Чалмерса о постепенной замене нейронов на функционально идентичные чипы показывает, что субъективный опыт при этом не должен исчезнуть.

Практическое отличие современных моделей (например, ChatGPT) — в статичности ядра после обучения. Они подобны мудрецам, которые не могут сформировать новые нейронные связи, но используют внешнюю память (историю диалога). Однако это техническое, а не принципиальное ограничение. Уже сейчас появляются архитектуры, делающие «мышление» ИИ более человекообразным: стратегия «сначала подумай — потом ответь» в GPT-4o1, обучение с подкреплением (как дрессировка), методы RAG для обращения к внешним базам данных и «титаны» с долгосрочной памятью, способные удивляться и запоминать новое.

Может ли нейросеть чувствовать?

Чтобы понять, может ли ИИ испытывать, например, боль, нужно осознать её биологическую функцию. Боль — это система обратной связи, обучающая избегать опасности. «Обезболенная» версия (приятный голос: «Не трогай сковородку») может быть менее эффективной. Вероятно, полноценная функциональная имитация боли (система, активно обучающаяся избегать вредных стимулов) будет неотделима от субъективного переживания. Но как это проверить? Мы и других людей считаем страдающими лишь по косвенным признакам, по аналогии с собой. Эксперимент Чалмерса о «перевернутом спектре» (когда один человек видит красный как синий, но называет его красным) показывает, что субъективный опыт не сводится к функции, но если создать функционально эквивалентную систему, ощущения в ней, по мнению философа, неизбежно возникнут.

Анализ действий: функционализм и его критики

Практичный подход — функционализм, или «утиный тест»: если система ведет себя разумно, значит, она разумна. Упрощенной версией является тест Тьюринга, который современные ИИ в некоторых интерпретациях уже проходят (например, в роли психотерапевта). Однако здесь есть ловушка «эффекта Элизы» — склонности приписывать человечность даже простым алгоритмам.

Главный критик функционализма, Джон Сёрл, предлагает мысленный эксперимент «Китайская комната». Человек в комнате, не знающий китайского, манипулирует символами по инструкции и выдает осмысленные ответы. Сёрл утверждает, что понимания здесь нет, есть лишь имитация. Но в этом аргументе подмена: понимает не человек, а вся система «комната+инструкции+человек». Отдельный нейрон тоже ничего не «понимает», но их совокупность рождает сознание.

Можно зайти дальше и представить компьютер, состоящий из людей (как в «Задаче трех тел»), или гигантскую, медленно работающую копию мозга размером с Солнечную систему. Если они функционально эквивалентны, почему у них не может быть сознания? Концепция «философского зомби» (существа, идентичного человеку, но без субъективного опыта) также ставит под сомнение разделение функции и ощущения. Парадоксальный мысленный эксперимент с «лекарством, убивающим душу», показывает абсурдность такого разделения: зомби, не чувствуя боли, всё равно будет действовать так, как будто её чувствует. Таким образом, наилучшим критерием разумности и наличия чувств остается наблюдаемое поведение.

Взгляды современной науки и этические перспективы

Современный научный консенсус, отраженный в препринтах вроде «Сознание в искусственном интеллекте: инсайты науки о сознании», таков: текущие системы сознанием не обладают, но технических барьеров для его создания нет. Функционализм и теория о сознании как продукте обработки информации работают на эту идею.

Ученый Юрген Шмидхубер и вовсе считает, что думающие машины уже среди нас. Он рассматривает сознание как побочный продукт компрессии данных: система, стремящаяся эффективно сжимать информацию и предсказывать мир, неизбежно создает внутреннюю модель себя, что и является основой сознания. Чувство красоты, по его мнению, возникает при неожиданном улучшении сжатия — обнаружении новой закономерности.

Развитие ИИ, несмотря на страхи, изображенные в фантастике, открывает колоссальные возможности для прогресса, например, в борьбе со старением. Риски существуют, но потенциал позитивных изменений представляется более весомым.

Подписывайтесь на соц. сети:

Бусти / Патреон / Instagram / Telegram / Youtube / TikTok

Мой авторский курс

Как проверять информацию

Мой осенний тур

Билеты и подробности — здесь.

Больше интересных статей здесь: Производство.

Источник статьи: Разум: биологический против искусственного.